Meta anuncia modelo IA de código abierto multisensorial

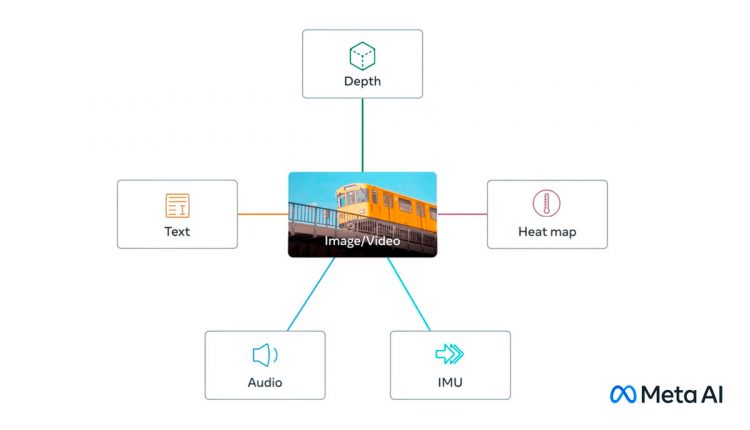

Meta ha anunciado que está desarrollando un proyecto de investigación sobre un modelo de inteligencia artificial de código abierto multisensorial. De esta manera, tiene distintos flujos de datos como datos visuales (imágenes y videos), audio, temperatura (imágenes infrarrojas), texto, información de profundidad y lecturas de movimiento.

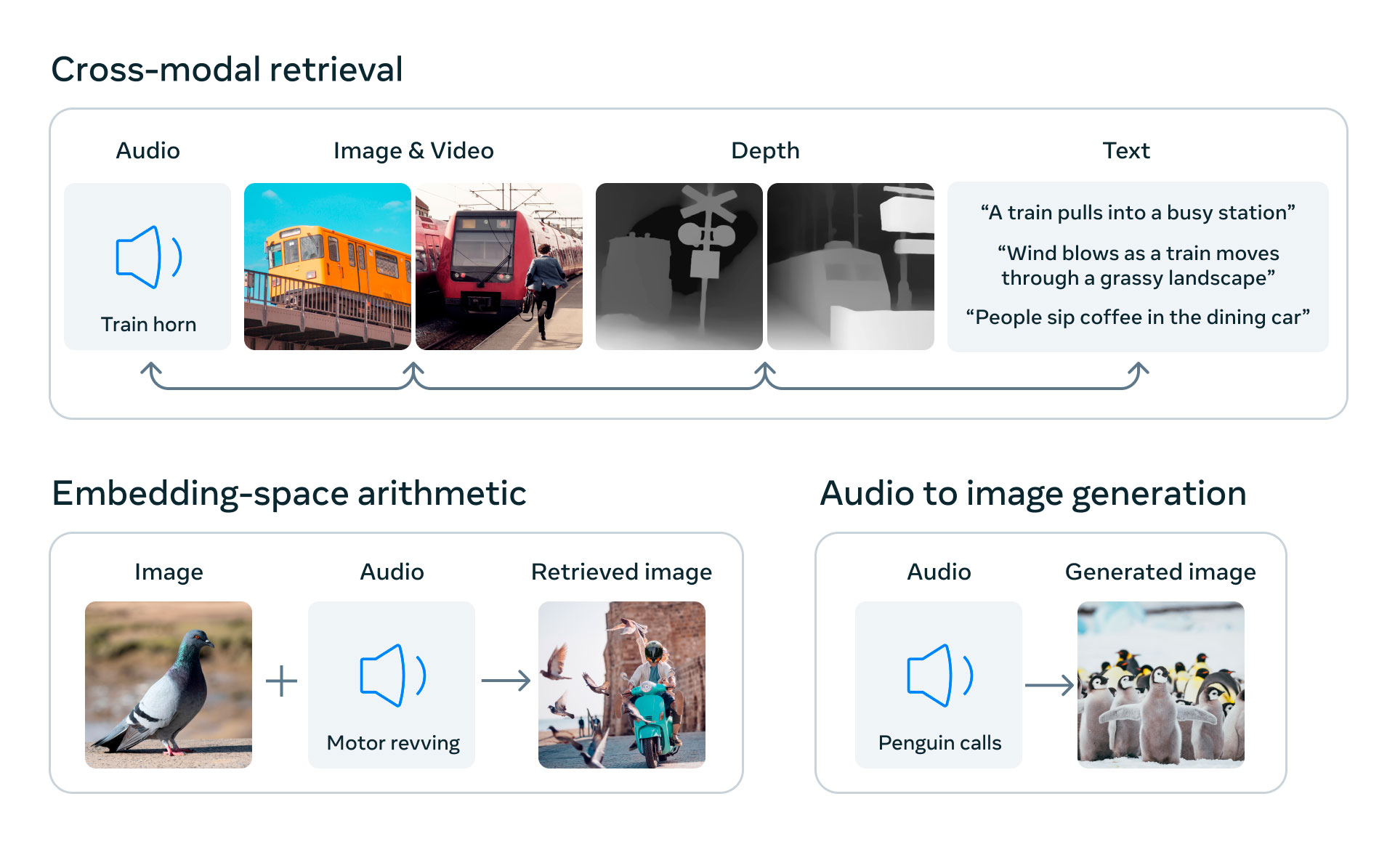

El objetivo principal de esta investigación es vincular todos los flujos de datos en un solo índice multidimensional. Algo muy parecido a lo que sucede con la inteligencia artificial generativa. Por poner un ejemplo, las IA de generación de imágenes como Midjourney utilizan sistemas para vincular texto e imágenes. De esta forma, enlazan la información de las descripciones con datos visuales. Ante esto, Meta dice que ImageBind es el primero en combinar los seis tipos de datos en un solo espacio de incrustación.

Por el momento, no está disponible para el consumo o ponerlo en práctica. Pero a diferencia de OpenAI y Google, Meta sigue compartiendo sus investigaciones sobre inteligencia artificial. OpenAI menciona que la práctica de código abierto puede ser dañina para los creadores, ya que otros pueden utilizarla y puede ser un potencial peligro. Mientras que otros como Meta, menciona que permite que terceros examinen los sistemas en busca de fallas y mejoras.